DISONÍVEL: https://www.facebook.com/146403135420555/photos/a.426844974043035.93821.146403135420555/1062692053791654/?type=3&fref=nf

ACESSO: 28/03/2016 as 10:02h

COM A FINALIDADE DE PROPORCIONAR AOS INTERESSADOS O ACESSO MAIS DINÂMICO ÀS REGRAS ORTOGRÁFICAS, A PÁGINA CANAL DE ENSINO DISPONIBILIZA APLICATIVO QUE PODE SER ACESSADO PELO LINK ABAIXO.

link: http://canaldoensino.com.br/…/academia-brasileira-de-letras… #Aplicativo

segunda-feira, 28 de março de 2016

COLETÂNEA DE ARTIGOS DE QUÍMICA

DISPONÍVEL: https://www.facebook.com/pesquisasdequimica/?fref=nf

ACESSO: 28/03/2016 as 9:47h

link:http://crispassinato.com/…/colecao-explorando-o-ensino-de-…/

ACESSO: 28/03/2016 as 9:47h

Há alguns anos, o MEC produziu uma coletânia de artigos que interessavam

aos professores de Ensino Básico em várias áreas, uma delas é a química

que a fonte principal utilizada foi a Revista Química Nova na Escola, da

SBQ. Estão disponíveis em pdf para serem baixadas. Boa leitura e novas ideias para suas aulas e

atividades com os alunos de suas respectivas escolas: expensquim_vol4

expensqui_vol5.

terça-feira, 22 de março de 2016

MICROCEFALIA

DISPONÍVEL: http://revistapesquisa.fapesp.br/2016/03/18/incertezas-sobre-a-microcefalia/

ACESSO: 22/03/2016 as 11:12h

Foi preciso atravessar meio mundo para o vírus zika deixar o

anonimato. Por quase 60 anos o vírus circulou pela África e pela Ásia

praticamente sem ser notado. Ao aportar no Brasil, porém, encontrou

condições favoráveis para se espalhar rapidamente e atraiu a atenção

internacional ao se tornar o principal suspeito do aumento nos casos de

microcefalia, um tipo de má-formação congênita da qual pouco se ouvia

falar no país.

Microcefalia é um termo de origem grega usado pelos médicos para

designar uma condição em que as crianças nascem com a cabeça pequena

demais para o tempo de gestação. A maioria delas, segundo especialistas,

é saudável. Apenas uma pequena parte nasce com microcefalia em

decorrência de problemas de desenvolvimento que deixam o cérebro menor.

Nesses casos, não há cura. Um bebê pode nascer com o cérebro pequeno

demais por causa de uma série de defeitos genéticos – há ao menos 16

genes conhecidos associados ao problema. Mas também pode ter

microcefalia em consequência de razões ambientais, como o consumo de

álcool ou exposição a produtos tóxicos na gestação, ou de uma série de

infecções, como as causadas pelo vírus da rubéola e do herpes, pelo

parasita da toxoplasmose ou pela bactéria da sífilis.

A possibilidade de o zika também causar o problema soou o alerta

geral pela facilidade com que o vírus se dissemina. Considerado

inofensivo por muito tempo, o zika entrou no Brasil entre 2014 e 2015 e,

segundo o Ministério da Saúde, já pode ter infectado 1,4 milhão de

pessoas. Nesse mesmo tempo, detectou-se um aumento nos casos de

microcefalia, em especial na região Nordeste. De 2000 a 2014, o

ministério registrou a média anual de 164 casos de microcefalia. Mas, de

outubro de 2015 a 20 de fevereiro deste ano, o número de casos

confirmados alcançou 583.

Em meio ao surto, políticos e autoridades da saúde chegaram a afirmar

que o país estaria diante da mais terrível epidemia dos últimos tempos,

que, se não fosse contida, poderia deixar toda uma geração de

brasileiros com danos neurológicos ou, como disseram, “sequelados”.

Começam a surgir evidências, porém, de algo que muita gente já

suspeitava: o número de casos de microcefalia sempre foi subestimado no

Brasil. Não conhecer bem a realidade anterior à entrada do zika no país

torna mais difícil saber se o problema está de fato aumentando – e, caso

esteja, de quanto é o aumento e qual proporção dele se deve ao vírus.

Nesse cenário, coletar dados que permitam conhecer como o problema

evolui ao longo do tempo é tão importante quanto estudar a melhor forma

de combater o vírus e o mosquito.

Uma indicação importante de que o sistema de saúde brasileiro não

identificava parte dos casos de microcefalia vem de um estudo recente

realizado por pesquisadores de Pernambuco e da Paraíba, os dois estados

que mais relataram nascimentos de bebês suspeitos de terem a cabeça

anormalmente pequena nos últimos meses.

Com a possibilidade de se estar diante de um surto do problema, a

médica Sandra da Silva Mattos, especializada em cardiologia fetal no

Recife, propôs um desafio à sua equipe. Ela coordena uma rede de

cardiologia que nos últimos anos acompanhou 100 mil recém-nascidos na

vizinha Paraíba. No final de 2015, Sandra recrutou 40 enfermeiras e

auxiliares de enfermagem de 21 maternidades paraibanas e pediu que

vasculhassem os registros das salas de parto para recuperar informações

sobre 10% das crianças.

Conseguiu-se mais. Em dezembro, elas revisaram as medidas do tamanho

da cabeça (perímetro cefálico) de 16.208 bebês nascidos entre 2012 e

2015 na Paraíba. O levantamento indicou que de 2% a 8% dessas crianças

poderiam ser classificadas como tendo microcefalia, dependendo do

critério adotado para definir o problema. Isso representa,

respectivamente, 320 e 1.300 recém-nascidos e não significa que todos os

casos suspeitos de microcefalia estejam necessariamente associados ao

vírus zika.

O importante é que mesmo o número menor, obtido pelo critério mais

restritivo e que representaria os casos mais graves de microcefalia, já

somaria cerca de metade da média anual de 164 casos que o Ministério da

Saúde registrava para todo o país por meio do Sistema de Informações

sobre Nascidos Vivos (Sinasc), a base de dados nacional que coleta

informações sobre os recém-nascidos brasileiros. Nessa base, há um campo

para inserir a medida do crânio, mas, como suspeitam vários

pesquisadores, muitas vezes ele não era preenchido – talvez porque a

notificação de microcefalia não fosse obrigatória anteriormente.

Aumento atípico

Nos últimos quatro meses o Ministério da Saúde identificou um número mais alto de casos de microcefalia, depois de alertado por médicos pernambucanos que haviam detectado um aumento atípico no nascimento de crianças com a cabeça menor que o considerado normal para o tempo de gestação.

Nos últimos quatro meses o Ministério da Saúde identificou um número mais alto de casos de microcefalia, depois de alertado por médicos pernambucanos que haviam detectado um aumento atípico no nascimento de crianças com a cabeça menor que o considerado normal para o tempo de gestação.

© CDC

Facilidade de disseminação do vírus zika (em vermelho) gerou medo de uma epidemia

De 8 de novembro de 2015 a 20 de fevereiro deste ano, nasceram no

país ao menos 5.640 bebês com essa característica. Esse número

corresponde a uma média de 46 novos casos suspeitos de microcefalia por

dia, uma proporção assustadoramente mais elevada do que a conhecida

anteriormente. De 2000 a 2014, a média registrada pelo Sinasc era de

aproximadamente um a cada dois dias. O aumento dos possíveis casos e a

associação deles com a infecção pelo vírus zika durante a gestação

alçaram a microcefalia para a posição de principal ameaça à saúde

pública nacional.

“O estudo da Paraíba é importante por mostrar, usando os critérios de

microcefalia adotados pelo ministério, que havia uma cegueira e o

Sinasc não estava detectando a maioria dos casos”, afirma o neurologista

pediátrico Fernando Kok, professor de neurologia infantil na Faculdade

de Medicina da Universidade de São Paulo (FM-USP).

Na realidade, a parcela identificada anteriormente pelo Sinasc era

ínfima. A cada ano nascem no Brasil aproximadamente 2,9 milhões de

crianças e os 164 casos de microcefalia notificados por ano de 2000 a

2014 representam apenas 0,006% desse universo. Esse número é muito baixo

quando comparado aos poucos dados conhecidos de outras populações. Os

Estados Unidos, por exemplo, adotam um critério semelhante ao brasileiro

para definir a microcefalia e apresentam uma proporção de casos mais

elevada.

Lá nascem por volta de 3,9 milhões de bebês por ano e, segundo uma revisão publicada em 2009 na revista Neurology,

os casos identificados de microcefalia beiravam os 25 mil. Isso

significa que aproximadamente 0,6% dos bebês norte-americanos tem

microcefalia e que lá o problema seria 100 vezes mais comum do que por

aqui.

Convertida em um número um pouco mais concreto para facilitar a

comparação, a taxa de 0,006% medida pelo Sinasc indica que apenas 60

recém-nascidos brasileiros em cada grupo de 100 mil teriam microcefalia e

deveriam ser encaminhados para mais avaliações. Já pela taxa mais

conservadora (2%) encontrada agora na Paraíba seriam 2 mil crianças em

cada grupo de 100 mil – ou 58 mil em todo o país.

É muito? Talvez não. Depende do critério usado para definir

microcefalia. No início de dezembro, o ministério passou a classificar

como suspeitas de terem microcefalia aquelas crianças cuja cabeça tem

menos de 32 centímetros (cm) de circunferência ao nascer. Médicos,

epidemiologistas e estatísticos costumam usar um gráfico bastante

simples para verificar se determinadas medidas apresentadas por um

indivíduo fogem muito ao padrão da população – em uma parte dos casos

essa diferença pode indicar algum problema de saúde.

O gráfico é construído ao se colocar no eixo horizontal as medidas

das cabeças das crianças de uma população e no vertical o número de

crianças. De modo geral, o tamanho da cabeça dos recém-nascidos humanos

tem entre 30 cm e 39 cm. Há quase 20 anos um levantamento encomendado

pela Organização Mundial da Saúde (OMS) a um consórcio internacional de

pesquisadores tomou várias medidas, entre elas a da cabeça, de 27 mil

crianças de diferentes populações, brasileira inclusive. Desse trabalho,

resultou um gráfico mostrando como se distribui o tamanho dos crânios

na população humana. Ele tem o formato de um sino e é apreciado pelos

estatísticos por apresentar propriedades matemáticas bem conhecidas.

Uma delas é que a média – nesse caso, a soma total das medidas das

cabeças dividida pelo total de crianças – separa o gráfico ao meio, em

duas partes simétricas (ver gráfico).

Os estatísticos sabem que a área total sob a curva representa toda a

população estudada e conseguem facilmente calcular a proporção de

pessoas que se encaixa em certas faixas da curva.

Médicos e epidemiologistas se baseiam nessas informações para saber

se uma determinada medida pode indicar um problema de saúde. A ideia

geral por trás desse tipo de ferramenta é de que tudo o que se afasta

muito do observado na maior parte das pessoas pode ser sinal de problema

– essas curvas são usadas, por exemplo, para avaliar se uma criança

está muito baixa e apresenta problemas de crescimento ou para saber se a

concentração de determinadas gorduras no sangue atingiu níveis nocivos à

saúde.

No caso do tamanho do crânio, os 32 cm adotados pelo ministério

representam o ponto de corte para definir se uma criança é suspeita de

ter microcefalia. Esse ponto provavelmente foi escolhido por se afastar

bastante do tamanho médio da cabeça da maioria dos recém-nascidos. A

partir de 37 semanas de gestação, a cabeça dos bebês considerados

saudáveis costuma medir algo em torno de 34,5 cm, segundo os dados da

OMS. A diferença pode parecer pequena, mas 2,5 cm é bastante para um

bebê.

Os

estatísticos usam uma medida chamada desvio-padrão para ter uma ideia

desse grau de afastamento. No gráfico em forma de sino, os 32 cm estão

aproximadamente dois desvios-padrão abaixo da média. Com base nas

propriedades da distribuição normal, sabe-se que uma parte pequena da

amostra, apenas 2,3%, está mais distante da média do que dois

desvios-padrão.

Os

estatísticos usam uma medida chamada desvio-padrão para ter uma ideia

desse grau de afastamento. No gráfico em forma de sino, os 32 cm estão

aproximadamente dois desvios-padrão abaixo da média. Com base nas

propriedades da distribuição normal, sabe-se que uma parte pequena da

amostra, apenas 2,3%, está mais distante da média do que dois

desvios-padrão.

Isso significa que 2,3% dos bebês nascidos no Brasil – o

correspondente a 66,7 mil crianças – poderiam se enquadrar na definição

de microcefalia do ministério. Uma proporção bem menor de recém-nascidos

(0,1% ou 2.900 bebês) tem a cabeça menor ainda. O tamanho do crânio

deles está três desvios-padrão abaixo da média e, na maioria dos casos,

indica problema no desenvolvimento cerebral.

“A grande maioria das crianças classificadas com microcefalia em

qualquer país que segue a recomendação da OMS [ou seja, aquelas que

estão dois desvios-padrão abaixo da média] será normal com a cabeça

pequena”, explica o epidemiologista Cesar Victora, da Universidade

Federal de Pelotas (UFPel). Ele conta que os casos patológicos,

associados ao zika e a outras infecções ou a problemas genéticos,

representam uma pequena minoria desses 66,7 mil. “A grande maioria

dessas crianças é normal e tem cabeça pequena por motivos genéticos não

patológicos. Elas têm a cabeça e o corpo pequenos porque seus pais são

pequenos ou porque elas sofreram algum tipo de restrição de crescimento

intrauterino, por exemplo, são filhos de mães que fumaram na gestação”,

diz Victora.

“O fato de o tamanho da cabeça estar abaixo de determinado valor não

significa necessariamente que há uma enfermidade”, lembra Kok, que

acompanha os casos de microcefalia no Hospital das Clínicas da USP. “É

preciso analisar a medida do crânio em conjunto com outras informações.

Agora, se a medida se afasta muito da média, é maior a probabilidade de

haver algum problema.”

Microcefalia invisível

Se a medida situada dois desvios-padrão abaixo da média for mesmo um bom indicador de microcefalia – em alguns países da Europa usam três desvios-padrão –, tanto no Brasil como nos Estados Unidos o sistema de saúde está deixando de avaliar muita criança que deveria ser tratada com mais atenção. Sabe-se que uma parte delas é saudável e não vai apresentar problemas de desenvolvimento neurológico no futuro, mas outra parte pode ter alguma enfermidade e mereceria passar por uma avaliação mais detalhada.

Se a medida situada dois desvios-padrão abaixo da média for mesmo um bom indicador de microcefalia – em alguns países da Europa usam três desvios-padrão –, tanto no Brasil como nos Estados Unidos o sistema de saúde está deixando de avaliar muita criança que deveria ser tratada com mais atenção. Sabe-se que uma parte delas é saudável e não vai apresentar problemas de desenvolvimento neurológico no futuro, mas outra parte pode ter alguma enfermidade e mereceria passar por uma avaliação mais detalhada.

No Brasil, o biólogo paulista Fernando Reinach foi um dos primeiros a

apresentar essas contas para um público mais amplo. Em sua coluna no

jornal O Estado de S.Paulo publicada em 6 de fevereiro, ele

chama a atenção para a divergência entre os números oficiais e os

esperados da microcefalia no Brasil. No texto “Microcefalia que sempre

existiu”, ele afirma: “Essas crianças deveriam ter sido identificadas e

examinadas com cuidado. Mas não foram, porque a notificação não era

obrigatória. Elas seguramente sempre existiram, mas não existem nas

estatísticas do Sistema Único de Saúde (SUS). Agora, com a notificação

obrigatória, e o pânico causado pelo zika, elas estão ‘aparecendo’. Esse

aparecimento súbito pode ser real, e causado pelo zika, ou pode ser uma

anomalia causada pela subnotificação no Brasil”, escreveu o biólogo.

Dúvida sem resposta

Assim como Reinach, alguns pesquisadores já entrevistados por Pesquisa FAPESP se queixaram da falta de dados históricos confiáveis sobre a microcefalia no país. A carência de informação dos anos anteriores, dizem, torna difícil saber se os números atuais estão crescendo só por causa do zika ou se há outros fatores envolvidos.

Assim como Reinach, alguns pesquisadores já entrevistados por Pesquisa FAPESP se queixaram da falta de dados históricos confiáveis sobre a microcefalia no país. A carência de informação dos anos anteriores, dizem, torna difícil saber se os números atuais estão crescendo só por causa do zika ou se há outros fatores envolvidos.

No final de dezembro, os pesquisadores do Estudo Colaborativo

Latino-americano de Malformações Congênitas (Eclamc), um consórcio

internacional que acompanha os registros de más-formações em 35

hospitais de sete países, revisaram os dados de microcefalia que haviam

registrado de 1967 a 2015 no Brasil e cruzaram com as informações

coletadas nos últimos três anos pelo Sinasc.

Em um relatório-síntese, disponível no site do grupo, os

pesquisadores afirmam que os números do Sinasc estavam subestimados.

Segundo os cálculos do Eclamc, são esperados dois casos de microcefalia

para cada grupo de 10 mil bebês nascidos no país, mas esse índice deve

ser mais elevado no Nordeste, onde o problema é mais comum do que nas

outras regiões. Usando o índice de microcefalia observado na Europa,

eles calcularam que deveria haver 45 casos entre os 147.597 bebês

nascidos em Pernambuco em 2015. Mas, até o fim de dezembro, o estado

havia reportado 1.153 casos suspeitos (26 vezes mais). Para os

pesquisadores, esses números só poderiam ser explicados se todas as

gestantes pernambucanas tivessem sido infectadas pelo vírus – no

documento não fica explícito qual proporção das mulheres infectadas

poderia transmitir o vírus ao feto.

Os pesquisadores do Eclamc suspeitam que boa parte do aumento seja

decorrente da identificação ativa de casos e concluem que os dados

atuais não permitem avaliar se houve um real aumento da prevalência de

microcefalia ao nascimento no Nordeste, qual a magnitude desse aumento e

se foi devido à exposição ao zika ou ao aumento de outras causas. A

equipe do Eclamc foi procurada, mas não quis dar entrevista.

Apesar

dessas considerações e da causalidade ainda não demonstrada, em meados

de fevereiro o ministro da Saúde, Marcelo Castro, disse que 40% dos

casos suspeitos de microcefalia notificados nos últimos meses estão

relacionados à infecção por zika.

Apesar

dessas considerações e da causalidade ainda não demonstrada, em meados

de fevereiro o ministro da Saúde, Marcelo Castro, disse que 40% dos

casos suspeitos de microcefalia notificados nos últimos meses estão

relacionados à infecção por zika.

O informe epidemiológico nº 14, divulgado pelo ministério no final de

fevereiro, indica que, dos 5.640 casos notificados de 8 de novembro a

20 de fevereiro, 1.533 já foram investigados e 583 (10,3% dos 5.640)

receberam a confirmação de microcefalia. Segundo o documento, exames

moleculares detectaram o material genético do zika em 67 dos 583 casos

confirmados. Nos 516 restantes a confirmação se deu por exames de

imagens do cérebro que permitiram observar lesões anteriormente

associadas ao zika. Ainda de acordo com o informe, o ministério suspeita

que a maior parte das mães dessas crianças teve zika. No entanto, não

deixa claro se nos 516 casos classificados por exames de imagem foi

eliminada a possibilidade de outras infecções

que provocam microcefalia (toxoplasmose, rubéola, citomegalovírus, herpes e sífilis).

O ministério não atendeu às solicitações de esclarecimentos.

que provocam microcefalia (toxoplasmose, rubéola, citomegalovírus, herpes e sífilis).

O ministério não atendeu às solicitações de esclarecimentos.

No informe epidemiológico nº 14 também não há detalhes sobre os 950

casos que foram excluídos. O documento sugere que as crianças não teriam

microcefalia de origem infecciosa, mas poderiam apresentar outra forma

do problema.

Sabe-se que as infecções não são a única causa de microcefalia – e talvez nem a mais comum. Na revisão de 2009 da Neurology,

de 15% a 50% dos casos de microcefalia podem ser de origem genética. Há

ao menos 16 genes conhecidos que causam o problema quando suas duas

cópias encontram-se alteradas. Além disso, fatores ambientais, como o

consumo de álcool na gestação ou a exposição a poluentes e produtos

tóxicos, também podem causar microcefalia. Quanto cada um deles

contribui para o total de casos? “Não conheço estudos que mostrem isso”,

diz Kok.

Um grupo de médicos e epidemiologistas do Rio Grande do Sul, de São

Paulo e do Ceará suspeita que a estratégia de considerar quem nasce com

crânio menor que 32 cm um potencial caso de microcefalia está incluindo

no pacote muitos bebês que são saudáveis.

Em um artigo publicado em fevereiro na revista Lancet, a

equipe coordenada por Cesar Victora, da UFPel, levantou várias razões

técnicas para isso. A primeira é que adotar uma nota de corte única para

bebês de ambos os sexos não é adequado, uma vez que as meninas, em

média, nascem menores que os meninos. Além disso, os pesquisadores

argumentam, 68% dos bebês brasileiros nascem antes de completar 40

semanas de gestação, em parte por causa das altas taxas de cesarianas, e

podem ser menores que o normal.

Para reduzir o número de bebês que não têm o problema – os chamados

falsos-positivos – entre os que passarão por mais avaliações, o grupo

sugere que se adotem curvas de padrão de crescimento mais adequadas à

realidade da população brasileira e com maior poder de detectar os casos

verdadeiramente positivos, como a produzida pelo consórcio Intergrowth

21st, que o grupo de Pelotas ajudou a desenvolver (ver Pesquisa FAPESP nº 225). Atualmente, além dos 32 cm para os bebês que nascem a partir da 37a

semana de gestação, o ministério adota uma curva de crescimento

produzida com crianças de países ricos, a curva de Fenton, para realizar

a triagem daqueles que nascem prematuros.

Para o médico e epidemiologista Eduardo Massad, também professor da

FM-USP, a infecção pelo vírus zika pode explicar parte do aumento dos

casos de microcefalia. “Exatamente quanto? Não se sabe”, afirma. Na

opinião dele, o importante é que se encontrou o vírus em 67 dos 583

casos confirmados, o que reforça a conexão do vírus com o problema,

embora ainda não demonstre conclusivamente uma relação de

causalidade.

causalidade.

“Existe uma associação inequívoca entre a infecção por zika na

gestação e o nascimento de bebês com microcefalia e há uma perfeita

plausibilidade em se atribuir parte do aumento de casos ao vírus”, diz

Massad. “Uma fração de fetos infectados desenvolve microcefalia, mas

ainda não se sabe o tamanho dessa fração.”

Rápido demais

No estudo da Paraíba, o grupo de Sandra Mattos detectou uma elevação principalmente nos casos graves de microcefalia a partir do terceiro trimestre de 2015, que poderia estar associada à circulação do vírus. Ela suspeita, porém, que se esteja concluindo rápido demais que o zika é único causador do problema. “Não queremos eliminar a influência do vírus, mas questionar se não haveria mais fatores envolvidos, como outras infecções e a subnutrição, comuns na população”, diz Sandra, que é diretora da Unidade de Cardiologia Materno-Fetal do Real Hospital Português de Beneficência de Pernambuco. “Precisamos conhecer bem com o que estamos lidando.”

No estudo da Paraíba, o grupo de Sandra Mattos detectou uma elevação principalmente nos casos graves de microcefalia a partir do terceiro trimestre de 2015, que poderia estar associada à circulação do vírus. Ela suspeita, porém, que se esteja concluindo rápido demais que o zika é único causador do problema. “Não queremos eliminar a influência do vírus, mas questionar se não haveria mais fatores envolvidos, como outras infecções e a subnutrição, comuns na população”, diz Sandra, que é diretora da Unidade de Cardiologia Materno-Fetal do Real Hospital Português de Beneficência de Pernambuco. “Precisamos conhecer bem com o que estamos lidando.”

As pesquisas epidemiológicas só estão começando. Na Paraíba, o grupo

de Sandra participa de um estudo com pesquisadores dos Centros de

Controle e Prevenção de Doenças (CDC) dos Estados Unidos e do Ministério

da Saúde que tem como objetivo verificar o risco de mulheres infectadas

terem filhos com microcefalia. Em São Paulo, pesquisadores da Rede

Zika, consórcio de cerca de 40 grupos de universidades e institutos de

pesquisa paulistas, financiado pela FAPESP, realizarão um estudo

semelhante.

Os resultados levarão meses para serem conhecidos. Segundo Massad,

também são necessárias mais pesquisas e mais longas – que acompanhem

toda a população e verifiquem qual proporção das gestantes é infectada

pelo vírus e tem filhos saudáveis ou com problemas.

Artigos científicos

SOARES DE ARAÚJO, J. S. et al. Microcephaly in northeast Brazil: a review of 16 208 births between 2012 and 2015. Bulletin of the World Health Organization. 4 fev. 2016.

ASHWAL, S. et al. Practice parameter: evaluation of the child with microcephaly (an evidence-based review). Neurology. v. 73. p. 887-97. 2009.

VICTORA, C. G. et al. Microcephaly in Brazil: how to interpret reported numbers?Lancet. 13 fev. 2016.

SOARES DE ARAÚJO, J. S. et al. Microcephaly in northeast Brazil: a review of 16 208 births between 2012 and 2015. Bulletin of the World Health Organization. 4 fev. 2016.

ASHWAL, S. et al. Practice parameter: evaluation of the child with microcephaly (an evidence-based review). Neurology. v. 73. p. 887-97. 2009.

VICTORA, C. G. et al. Microcephaly in Brazil: how to interpret reported numbers?Lancet. 13 fev. 2016.

sexta-feira, 18 de março de 2016

AUSÊNCIA DE SANEAMENTO, ACUMULO DE LIXO, LAMA.......E OUTROS PROBLEMAS DE ORDEM SOCIAL CONTRIBUEM PARA AUMENTO NA INCIDÊNCIA DE LEPTOSPIROSE

DISPONÍVEL:http://revistapesquisa.fapesp.br/2016/02/19/mais-risco-de-leptospirose/

ACESSO:18/03/2016 as 09:47h

Sujeitas a alagamentos e sem acesso a saneamento básico, as favelas

são áreas em que o risco de contrair leptospirose é reconhecidamente

elevado. Mas esse risco não é sempre igual. Certas áreas podem

apresentar uma taxa de transmissão maior dessa infecção, provocada por

uma bactéria encontrada com frequência na urina de roedores. A fim de

identificar os fatores que aumentam a transmissão, pesquisadores da

Fundação Oswaldo Cruz (Fiocruz) na Bahia, trabalhando com equipes dos

Estados Unidos e da Inglaterra, acompanharam durante quatro anos cerca

de 2 mil moradores da favela Pau da Lima, uma área em que a leptospirose

é endêmica em Salvador. Analisando os casos de infecção ocorridos no

período, os pesquisadores constataram que a transmissão de leptospirose é

influenciada tanto por características ambientais como sociais. As

famílias que vivem nas áreas de relevo mais baixo e próximo a córregos,

em geral menos valorizadas, correm mais risco de ser contaminadas. O

risco também é maior para adultos, jovens e do sexo masculino, em

especial os que trabalham com coleta de lixo ou construção e estão mais

expostos à lama, ao solo e a outros materiais contaminados (PLoS Neglected Tropical Diseases, 15 de janeiro).

A FLORA CONTRA A FAUNA

DISPONÍVEL:http://revistapesquisa.fapesp.br/2016/02/19/plantas-contra-o-mosquito/?cat=tecnociencia

ACESSO: 18/03/20156 as 09:44h

ACESSO: 18/03/20156 as 09:44h

O óleo extraído dos frutos e sementes da sucupira-branca, uma árvore do

Cerrado brasileiro, e o suco das folhas do sisal, uma planta originária

do México e cultivada no Brasil para extração de fibras, possuem

propriedades capazes de eliminar totalmente as larvas do Aedes aegypti,

o mosquito transmissor da dengue, zika e chikungunya, de acordo com

dois grupos de pesquisadores brasileiros. O óleo da sucupira (Pterodon emarginatus)

foi utilizado por pesquisadores das universidades federais do Amapá

(Unifap), Goiás (UFGO) e Fluminense (UFF) para desenvolver uma

nanoemulsão que diluída em água funciona como larvicida. O estudo foi

financiado pelo Conselho Nacional de Desenvolvimento Científico e

Tecnológico (CNPq) e pela Fundação de Amparo à Pesquisa do Estado do

Amapá (Fapeap) e publicado na revista Plos One de 7 de janeiro.

O produto que eles concluíram não utiliza solventes no preparo e não é

tóxico ao ambiente ou para seres humanos. O mesmo princípio vale para o

larvicida desenvolvido com folhas de sisal (Agave sisalana) por

pesquisadores da Universidade Federal da Paraíba (UFPB) e Embrapa

Algodão, de Campina Grande (PB). De acordo com os pesquisadores, o suco

ataca o intestino das larvas e as elimina na totalidade. Eles fizeram o

mesmo teste em outras fases do inseto, como ovo, pupa e adulto, e o

produto não teve efeito. A explicação é que a larva se alimenta da

solução e provavelmente morre de indigestão com o produto. Para ser

disponibilizado ao mercado, o larvicida deverá ser oferecido na forma de

pó para diluição em água porque o suco in natura se degrada

rapidamente. A pesquisa teve as parcerias do Sindicato das Indústrias de

Fibras Vegetais do Estado da Bahia e da Organização das Nações Unidas

para Agricultura e Alimentação (FAO).

Rejeitos da minerção usados na construção

DISPONÍVEL:http://revistapesquisa.fapesp.br/2016/02/19/rejeitos-da-mineracao/?cat=tecnociencia

ACESSO:18/03/2016 as 9:31h

ACESSO:18/03/2016 as 9:31h

Soluções para os rejeitos de mineração como aqueles que provocaram o

acidente em Mariana, da barragem da empresa Samarco, foram apresentadas

por pesquisadores da Universidade Federal de Minas Gerais (UFMG) antes

mesmo de ocorrer o problema ambiental que atingiu moradores da região e o

rio Doce. Sob a coordenação dos professores Evandro da Gama e Abdias

Gomes, eles conseguiram terminar em 2015, antes do desastre ambiental,

uma casa com 46 metros quadrados (m2) com produtos originados

de rejeitos e estéreis da mineração de ferro. O rejeito é o que sobra

do processamento do minério de ferro e o estéril são rochas que ficam

junto com o itabirito, a rocha que contém o minério. Os dois são

estocados nas barragens. “Tirando telhas, vidros, pisos internos e

portas, tudo pode ser feito com os materiais que sobram da mineração”,

diz Evandro. “Nós desenvolvemos um forno de calcinação chamado Flex, que

calcina a poeira e a transforma em micropartículas que depois serão

transformadas em areia, blocos, vigas, pedra e cimento para a construção

civil”, explica o pesquisador. Evandro coordena o Laboratório de

Geotecnologias e Geomateriais do Centro de Produção Sustentável da UFMG,

em Pedro Leopoldo (MG). Evandro garante que o aproveitamento dos

rejeitos e dos estéreis tornaria desnecessárias as grandes barragens não

só da mineração de minério de ferro como também de bauxita, ouro,

fosfato e calcário. Outra vantagem é que o material rejeitado processado

e utilizado na construção civil deixa as casas menos quentes e com

paredes que absorvem menos água.

Produzidos artificialmente, quatro elementos químicos passam a integrar a tabela periódica; segue a busca por outros, mais estáveis

DISPONÍVEL:http://revistapesquisa.fapesp.br/2016/02/19/a-procura-dos-numeros-magicos/?cat=ciencia

ACESSO: 18/03/2016 as 09:13h

O ano de 2016 começou com os jornais noticiando a redecoração das

paredes dos laboratórios de química em todo o mundo. É que, de um

momento a outro, ficaram desatualizados os pôsteres exibindo a famosa

tabela periódica, a lista que organiza os elementos químicos conhecidos

segundo suas características e propriedades. Em um comunicado à imprensa

no dia 30 de dezembro de 2015, a União Internacional de Química Pura e

Aplicada (Iupac) e a União Internacional de Física Pura e Aplicada

(Iupap) reconheceram oficialmente a existência de quatro elementos

químicos descobertos nos últimos anos. São os elementos de número 113,

115, 117 e 118, ainda sem um nome oficial, que se somam aos 114

identificados anteriormente.

Os novos elementos químicos são chamados de superpesados porque

abrigam em seu núcleo um número elevado de prótons (partículas de carga

elétrica positiva), muito superior ao dos elementos químicos encontrados

na natureza. É esse conjunto de prótons, o chamado número atômico, que

distingue um elemento químico do outro e define muitas de suas

características. Por exemplo, o carbono, que constitui a maior parte da

massa dos seres vivos, abriga em seu núcleo apenas seis prótons. À

temperatura ambiente e puro, o carbono forma cristais que podem ser

negros e macios, caso da grafite, ou transparentes e duro, como o

diamante, dependendo de como os átomos estão geometricamente

organizados. Já o elemento químico natural mais pesado, o urânio, é um

sólido metálico bastante denso e radiativo. Tem 92 prótons e, ainda

assim, é bem mais leve que os quatro acrescentados agora à tabela

periódica.

Os novos elementos são dificílimos de observar e não devem existir

espontaneamente na natureza – ao menos, não por muito tempo. Por terem

núcleos superpesados, são tão instáveis e fugazes que se desfazem em

frações de segundo. A existência deles só pôde ser confirmada por meio

de uma série de experimentos realizados ao longo da última década.

Um dos poucos laboratórios capazes de fabricar esses elementos está

no Instituto Riken, no Japão. Foi lá que, em 2004, identificou-se o

elemento 113. Outros laboratórios com a mesma capacidade estão no

Instituto Conjunto para Pesquisa Nuclear, em Dubna, na Rússia, e em

centros nos Estados Unidos. Uma colaboração entre uma equipe de Dubna e

pesquisadores norte-americanos, a maioria do Laboratório Nacional

Lawrence Livermore, produziu o elemento 115 em 2004, o 118 em 2006 e o

117 em 2010.

Com os quatro novos elementos químicos, somados aos elementos 114 e

116, cuja existência foi reconhecida em 2011, finalmente foram

preenchidos todos os espaços vagos na sétima linha da tabela periódica.

“Só nos últimos 50 anos, 17 novos elementos químicos foram acrescentados

à tabela, do 102 ao 118”, diz o físico Edilson Crema, do Instituto de

Física da Universidade de São Paulo (USP).

“Quando o químico francês Antoine Lavoisier publicou em 1789 o Tratado elementar de química,

considerado um marco da química moderna, a obra listava apenas 33

elementos”, observa o químico e historiador da ciência Carlos Alberto

Filgueiras, da Universidade Federal de Minas Gerais (UFMG). Naquela

época a identificação de novos elementos químicos dependia do

desenvolvimento de produtos e métodos de extração para estudar os

minerais. “A análise das propriedades de novos minerais muitas vezes

revelava a presença de um elemento químico até então desconhecido”,

explica.

A tabela periódica só surgiria no final dos anos 1860. Os químicos já

haviam então percebido que os elementos, enfileirados em ordem

crescente de massa atômica (a soma de seus prótons e nêutrons), formavam

séries com propriedades físicas e químicas semelhantes, que se repetiam

periodicamente ao longo da fila. A partir dessas observações, o químico

russo Dmitri Mendeleev ordenou os 65 elementos identificados até então

no que chamou de tabela periódica dos elementos químicos. Ele previu a

existência de outros, como o gálio e o germânio, só descobertos anos

depois.

Depois de preencherem quase todas as lacunas da tabela periódica

entre o hidrogênio, que tem 1 próton, e urânio, com 92, começou-se a

usar aceleradores de partículas nos anos 1940 para tentar produzir

elementos químicos mais pesados que o urânio. Os primeiros elementos

químicos sintéticos eram formados pela adição de um nêutron, que, ao

aderir ao núcleo, converte-se em um próton, liberando um elétron e um

neutrino. Essa estratégia funcionou até o férmio, que tem 100 prótons. A

partir daí, os elementos pesados passaram a ser criados pela colisão e

fusão de dois núcleos mais leves.

A produção desses elementos exige um ajuste fino entre as massas dos

núcleos e a energia com que são lançados uns contra os outros. É que a

colisão tem de ocorrer com energia suficiente para vencer a força de

repulsão entre os núcleos, que têm carga elétrica positiva. Mas a

energia não pode ser elevada demais a ponto de impedir a formação de um

núcleo maior e estável, ainda que por instantes. O objetivo dos físicos

não é apenas fabricar elementos químicos novos. Essa é também uma forma

de testar as teorias sobre como prótons e nêutrons interagem e a matéria

se comporta num nível ainda mais elementar. Essas teorias explicam como

os elementos mais leves – como hidrogênio, hélio e lítio – se formaram

na explosão que teria dado origem ao Universo, o Big Bang, e depois

produziram os demais elementos por fusão nuclear no interior de estrelas

e durante as explosões que as extinguem.

O núcleo dos átomos é uma região em constante tensão. Os prótons se

repelem mutuamente por terem carga elétrica de mesmo sinal, positiva. Só

se mantêm unidos pela ação de uma força contrária, de atração: a força

nuclear forte. Esse equilíbrio entre essas forças é bastante delicado.

Segundo Crema, os núcleos, além de prótons, contêm certo número de

nêutrons, partículas eletricamente neutras. “Os nêutrons são uma espécie

de estabilizadores nucleares”, diz. “Núcleos com muitos prótons exigem

um número ainda maior de nêutrons em relação ao número de prótons, o que

torna mais difícil formar núcleos superpesados.”

Uma teoria chamada de modelo de camadas propõe que, no núcleo dos

átomos, os prótons e os nêutrons se encontram organizados em camadas

concêntricas, cada uma delas comportando um número máximo de partículas –

o chamado número mágico. De acordo com esse modelo, quanto mais

completa a camada externa de um núcleo, mais estável ele é. Essa ideia,

em princípio, explica por que alguns núcleos pesados se desmancham

facilmente enquanto outros existem por mais tempo. Os físicos esperam

fabricar elementos contendo números mágicos de partículas. Eles teriam

chance de se manter estáveis por vários anos e permitiriam iniciar uma

oitava ou até mesmo nona linha na tabela periódica. “Mas isso”, diz

Crema, “ainda é só conjectura e esperança”.

quarta-feira, 16 de março de 2016

O Diagrama de Pauling sempre é válido? Conheça o Digrama de Rich-Suter

DISPONÍVEL: http://universidadedaquimica.com.br/artigos/diagrama-pauling-rich-suter/

ACESSO: 16/03/2016 as 11:44h

Sobre o autor

ACESSO: 16/03/2016 as 11:44h

Um belo padrão

Todo aluno

de química utiliza o velho e bom Diagrama de Pauling para realizar a

distribuição eletrônica dos elementos. Esse Diagrama, que o próprio

Linus Pauling nunca reclamou a autoria, é uma forma simples e rápida de

determinar a estrutura eletrônica dos átomos, no entanto, muitos o

utilizam mesmo sem saber sua origem, ou seu significado. Alguns acham

que o Diagrama é uma consequência direta do modelo atômico de Bohr, o

que é um grande equívoco, uma vez que o belo e fantástico Modelo de Bohr

(porém falho) não compreende o conceito de orbitais. E o Diagrama de

Pauling nada mais é do que um fila de energia dos orbitais, onde o de

mais baixa energia é o orbital 1s, seguindo pelo 2s, 2p, 3s e assim por

diante. A construção do diagrama tem uma origem híbrida, baseada tanto

na teoria quanto dos resultados experimentais. Seu fundamento pela

teoria está em sua própria estrutura, porque o que simplesmente

representamos como 1s, 4p, 5d … nada mais são do que funções matemática

advindas da mecânica quântica. Os resultados experimentais orientam a

ordem energética, pois indica claramente que orbitais do mesmo nível,

como 2s e 2p, não possuem a mesma energia (no caso das funções de onda

do hidrogênio, onde a mecânica quântica é exata, esses orbitais tem a

mesma energia); mostra que o orbital 4s tem energia inferior ao 3d, além

de outros casos análogos (conclusão fundamentada por resultados

experimentais); omite de orbitais teoricamente existentes, porém sem

observação experimental como o 5g, 6h, e outros.

Não restam

dúvidas sobre a praticidade, e a aplicabilidade desse diagrama. Sua

importância é tamanha que, em qualquer nível de ensino de química, do

médio à pós-graduação, seja nas aulas expositivas, seja em livros

acadêmicos, ele ainda é utilizado. No entanto, deve ser utilizado com

cautela. Por que? Nós utilizamos, e ensinamos, esse diagrama como uma

referência a qual todos os elementos devem seguir. Mas será que a

natureza, assumindo que o orbitais de fato existem, seria tão obediente e

previsível assim? TODOS os mais de 110 elementos que conhecemos, sendo

natural ou artificial, iriam obedecer esse padrão? É razoável que não...…

os elementos artificiais, mais pesados, com tempo de vida curto,

dificilmente obedeceriam alguma regra. Mas.…os mais comuns, os elementos

do dia-a-dia, devem obedecer. Será mesmo?

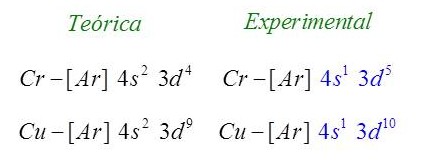

Cromo, cobre e seus familiares

Podemos

dar uma olhada em dois elementos muito comuns, o cobre e o cromo, que

simplesmente não obedecem o Diagrama. Abaixo temos a configuração

eletrônica teórica, ou seja, a prevista seguindo o diagrama, e a real,

de acordo com os dados experimentais.

Esse é um caso bem conhecido, e a resposta padrão para ele é dizer que:

Como os orbitais d são degenerados, o ideal é que todos tenham o mesmo preenchimento, seja parcialmente preenchido, seja totalmente preenchido, a para isso, existe a transferência interna de um elétron do orbital s para o orbital d

De fato,

se os orbitais d têm a mesma energia, então como podemos ter quatro

orbitais parcialmente preenchidos, e um “vazio”, e os cinco serem

idênticos do ponto de vista energético? Por isso gerar um “desiquilíbrio

energético”, parece que a natureza seguiu uma distribuição mais

simétrica no caso do cobre e do cromo. Até que essa explicação funciona

bem, porque o mesmo é observado para o molibdênio, que é um “parente”

do cromo, e para a prata e o ouro, que são análogos ao cobre.

Normalmente vai até ai nossa explicação sobre distribuição eletrônica.

Falamos que o Diagrama de Pauling é o modelo perfeito, mas devido a

essas “circunstâncias energéticas”, a família do cobre e a família do

cromo não o obedecem. Mas nem todos os membros de uma família seguem a

tradição! Quando olhamos para a configuração eletrônica do tungstênio,

que deveria seguir o padrão do cromo e do molibdênio, percebemos que ele

segue a distribuição tradicional de Pauling. E ai?

São muitos os rebeldes!

Como

explicamos o caso do obediente tungstênio? … Quando olhamos com um pouco

mais de atenção observamos que outros elementos não obedecem ao

Diagrama, e nem tem sua configuração eletrônica contemplada pela mesma

explicação do caso do Cr e do Cu. Vejam os casos abaixo.

Viram?

Nióbio, rutênio, ródio, paládio, platina, além de uma grande número de

lantanídeos e actinídeos (não mostrados) desobedecem abertamente o

Diagrama de Pauling!!! Serão todos esses elementos exceções? Quando

explicamos isso em sala de aula chamamos atenção a esses casos? Ou

varremos para baixo do tapete, não os mencionamos, e torcemos para que

nenhum aluno pergunte sobre eles? Quando perguntam, falamos simplesmente

que são exceções?

Não, esses

casos não são exceções! Essa é a realidade! O bom Diagrama funciona bem

para uma série de elementos, em especial, os representativos, mas falha

ao descrever a estrutura eletrônica de vários metais. A natureza nunca

foi tão obediente mesmo … mas não é por isso que o Diagrama não tenha o

seu mérito. Mas ai? Só isso? O Diagrama de Pauling não funciona para

esses elementos e não tem nenhuma explicação para essas observações?

Do Facebook ao Diagrama de de Rich-Suter

Como a

maioria dos meus colegas de profissão, eu passava por cima desses casos …

até que em uma discussão num grupo de professores de química no

Facebook, um colega perguntou como explicávamos esses casos. Vários,

incluindo eu, deram suas opiniões sobre isso – nada muito diferente do

que está descrito até agora nesse post. Mas outro colega, que eu

infelizmente não lembro o nome, sugeriu olharmos para o Diagrama de

Rich-Suter.

Até o

momento, eu nunca havia ouvido falar nesse diagrama, e decidi procurar

na literatura. Para o meu espanto, achei um artigo da Química Nova,

escrito por professores da UFRJ (dois deles eu conheço pessoalmente),

onde faziam a apresentação desse diagrama como uma “alternativa

elegante” para explicarmos os casos onde o Diagrama de Pauling falha, e

ao mesmo tempo criticavam como essa ferramenta sequer é citada nos

livros mais comuns de Química Inorgânica!

Após

ler esse artigo procurei o artigo original do Rich e do Suter, mas não

tive acesso. É um artigo do Journal Chemical Education, de 1988, mas

infelizmente a Capes não assina esse valioso periódico. Mas pelo artigo

da Química Nova deu para entender como funciona esse diagrama, e é isso

que eu tentarei explicar agora.

Entendendo o Diagrama de Rich-Suter

Hoje, e já

há algum tempo, temos métodos computacionais para resolver, com

aproximações, a função de onda de Schrödinger para átomos

polieletrônicos. Esses métodos nos fornecem, dentre outras coisas, a

energia dos orbitais atômicos. O que o Rich e o Suter fizeram foi

aplicar um desses métodos (não sei qual porque não consegui acesso ao

artigo original) a cada um dos elementos das séries de transição, e

avaliar a energia dos orbitais ns (n-1)d (no caso da primeira série

seria 4s3d, da segunda 5s4d, e da terceira 6s5d). Os resultados obtidos

nesses casos são mais confiáveis que a série Energética de Pauling, e se

tivessem uma versão hoje, seriam ainda mais confiáveis. A principal

característica desses diagramas é que a energia dos elétrons de spin α e

spin β, com a mesma parte espacial da função de onda, não é a mesma.

Isso significa que os dois elétrons do orbital 4s, por exemplo, por

terem momento angular de spin diferentes, apresentam energia diferente.

Isso pode soar um pouco estranho, mas quem conhece o mundo da Modelagem

Molecular sabe que esse é uma forma padrão dos softwares

resolverem as Funções de Onda. São os chamados métodos irrestritos, e

são bem aceitos pela comunidade acadêmica especializada na área.

Tá, mas… e ai? Como esse diagrama desconhecido resolve o problema do bom e velho Diagrama de Pauling?

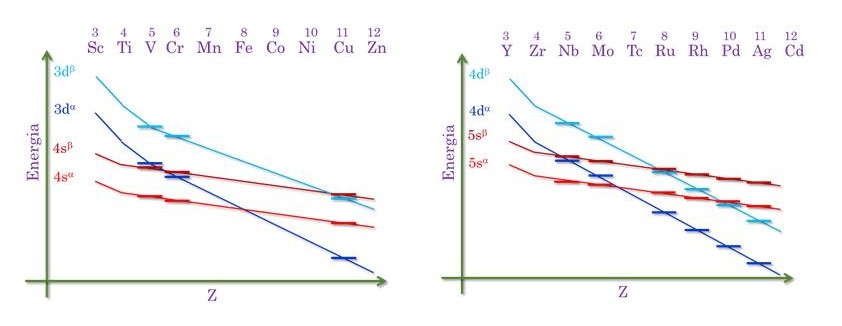

Abaixo eu tenho uma figura adaptada do digrama de Rich-Suter para a primeira e a segunda série de transição.

A curvas

avermelhadas representam a energia dos orbitais s, enquanto que as

curvas azuladas se indicam a energia dos orbitais d. Na verdade, cada

curva dessas é um interpolação de pontos, que representam a energia de

cada orbital. No eixo x tem-se a carga nuclear. Percebam que em todos os

casos a energia dos orbitais diminuem com o aumento da carga nuclear,

afinal esses ficam mais próximos do núcleo, e portanto mais

estabilizados. Entretanto, a taxa com que os orbitais d se estabilizam é

maior do que os orbitais s. Uma forma racional de se entender isso é

que, os orbitais d, para qualquer série de transição, estão mais

próximos do núcleo do que os orbitais s representados, e portanto eles

sofrem maior influência com o aumento da carga nuclear. Na verdade, ai

reside o segredo do Diagrama de Rich-Suter. Para cada átomo a energia

dos orbitais d e s são diferentes, às vezes seguem a sequência de

Pauling, e isso acontece com o primeiros elementos de cada série, às

vezes o comportamento é completamente oposto (tudo isso obtido pelos

cálculos quânticos computacionais). Na hora de fazermos a distribuição

eletrônica, devemos primeiro adicionar os elétrons nos orbitais de mais

baixa energia, de acordo com o digrama, para então adicionar nos de mais

alta energia (seguindo o princípio de AufBau). Antes de fazermos alguns

exemplos, tenho de chamar atenção a um detalhe importante. Um orbital

4sα só pode representar um elétron, porque no 4s temos apenas um elétron

com spin α (o mesmo vale para o 4sβ). No entanto, um 3dα representa 5

elétrons degenerados, pois em cada subnível d temos até 5 elétrons com

spin α, e os outros 5, se for o caso, serão de spin β. Dito isto, vamos

pegar três exemplos, o vanádio, que obedece Pauling, o cobre que não

obedece, mas sabemos explicar, e o rutênio que é um dos casos críticos.

Entre os

orbitais s e d, o vanádio tem 5 elétrons. O orbital de mais baixa

energia é um 4sα, seguido de um 4sβ. Esses dois elétrons representam a

configuração 4s2. Sobram 3 elétrons que serão alocados no próximo orbital de mais baixa energia que é o 3dα. Isso leva à configuração 4s23d3, seguindo o diagrama.

No caso do

cobre, com 11 elétrons no total, a posição relativa dos orbitais está

mudada. A carga nuclear sobre os elétrons é tão forte que provoca esse

reordenamento dos orbitais. Então … vamos lá. Ficam 5 elétrons no 3dα,

que é o mais estável. O próximo orbital é o 4sα, que fica com um

elétrons. Os 5 elétrons restantes vão para o próximo orbital na fila de

energia, que é o 3dβ. A configuração do cobre tem portanto, 10 elétrons

no orbital 3d e apenas 1 no 4s, como havíamos concluído com a explicação

do “desequilíbrio energético”. Mas será que o diagrama é capaz de

explicar os demais átomos? Vamos ao rutênio então.

O rutênio tem 8 elétrons, e possui a distribuição dita “anômala”. Pelo diagrama de Pauling sua configuração seria 5s24d6, mas sua configuração real é 5s14d7

(e neste caso, não vale a explicação dada ao cromo e ao cobre). Dos 8

elétrons, 5 já ficam no 4dα, seguido de 1 elétron no 5sα. Os dois

elétrons restantes vão para o 4dβ. Pelo diagrama de Rich-Suter a

configuração é 5s14d7, idêntica à experimental. Legal, não é?

Vale

ressaltar que o diagrama falha em prever a configuração de vários

elementos do bloco f. Isso se deve ao método quântico utilizado não ser

muito adequado para prever a energia desses orbitais. Mas isso não é de

admirar. Hoje, em 2015, ainda não temos um método quântico computacional

tão bom assim, imagina em 1988?

Mas ai?

Teremos coragem de falar desse Diagrama em nossas aulas, em especial na

Graduação? No Ensino Médio também é válido, mesmo sabendo que os alunos

não tem base para isso. É melhor eles saberem que tem uma resposta, mas

que no momento não saberiam compreendê-la, do que jogar no grande saco

das “exceções”. É uma pena que uma ferramenta versátil como essa não

esteja nos livros mais comuns. Mas como professores não devemos ficar

presos apenas aos livros. Devemos ler artigos, procurar na literatura,

ver o que tem sido feito de novo. Queremos essa independência de nossos

alunos, logo devemos ser o exemplo para eles!!!

Sobre Antonio Florencio

Sou professor, mestre e doutor em química. Nerd assumido, e muito

fã de animes, Marvel/DC, Turma da Mônica, etc. Hoje minha principal

preocupação é fazer os alunos de química, e a sociedade como um todo,

enxergarem que entender química significa entender a natureza, a

evolução da sociedade, a vida.

Assinar:

Comentários (Atom)